Apple vill hindra spridning av porr till barn samt barnpornografi till vuxna.

I och med att nästa version av operativsystemen till Apples olika produkter kommer man påbörja automatiskt genomsökning iCloud och meddelande som skickas via Apples egna Meddelande-tjänst.

Det hela är uppdelat i tre steg. För närvarande kommer det endast gälla amerikanska användare.

Porrfilter i Meddelande-appen

Om ett foto av så kallad ”sexuell natur” skickas till eller från ett barn så kommer det inte visas direkt. I stället kommer ett varningsmeddelande fram om att bilden kan vara av ”känslig natur” och de får välja om de skall titta på den. Det samma gäller om barnet är den som skickar bilden. Barnets föräldrar kommer också få reda på vad som pågår och detta informeras även barnet om. Ett barn är i detta fall någon som är under 13 år och är en del av Apples Familjedelning.

Funktionen är en del av själva appen och inte Apples meddelandetjänst vilket betyder att det gäller både SMS och meddelanden som går via Apples servrar. Ingen utom föräldrar och barnet kan se vad som pågår och det är något som föräldrar aktivt måste aktivera.

Detta kommer gälla Meddelande-appen på iOS 15, iPadOS 15 och macOS Monterey.

Identifiering av barnpornografi iCloud-bilder

Innan en bild laddas upp till Bilder i iCloud kommer en genomsökning ske som sedan matchas mot en databas som amerikanska National Center for Missing and Exploited Children (NCMEC) står bakom. Matchningen sker genom att att bilddatan envägsomvandlas till ett beskrivande värde, så kallade hashing. Lite som lösenord hanteras idag, ingen kan läsa dem men de kan jämföras med en existerande databas.

Här är det viktigt att poängtera att systemet inte ser bilden för vad den är, inte heller två olika bilder tagna vid samma tillfälle på samma motiv kommer kunna matchas ihop. Utan det är om redan existerande foton, som finns i NCMECs databas, sprids via iCloud Bilder som den flaggas. Detta gäller även om bilden är beskuren eller på annat sätt förändrats. Det betyder att användarnas egna foton på sina barn, spritt språngande nakna eller ej, inte påverkas på något vis.

Skulle flera bilder flaggas från samma användare går det till en manuell bedömning hos Apple som sedan tar det vidare till NCMEC och polisära myndigheter. Enligt Apple är systemet mycket säkert och man räknar med en felrisk på mindre än en på en biljard, per år.

Detta gäller iOS 15 samt iPadOS 15. Ej macOS.

National Center for Missing and Exploited Children är tillsatt av amerikanska regeringen och den enda organisation som lagligt får inneha denna typen av material.

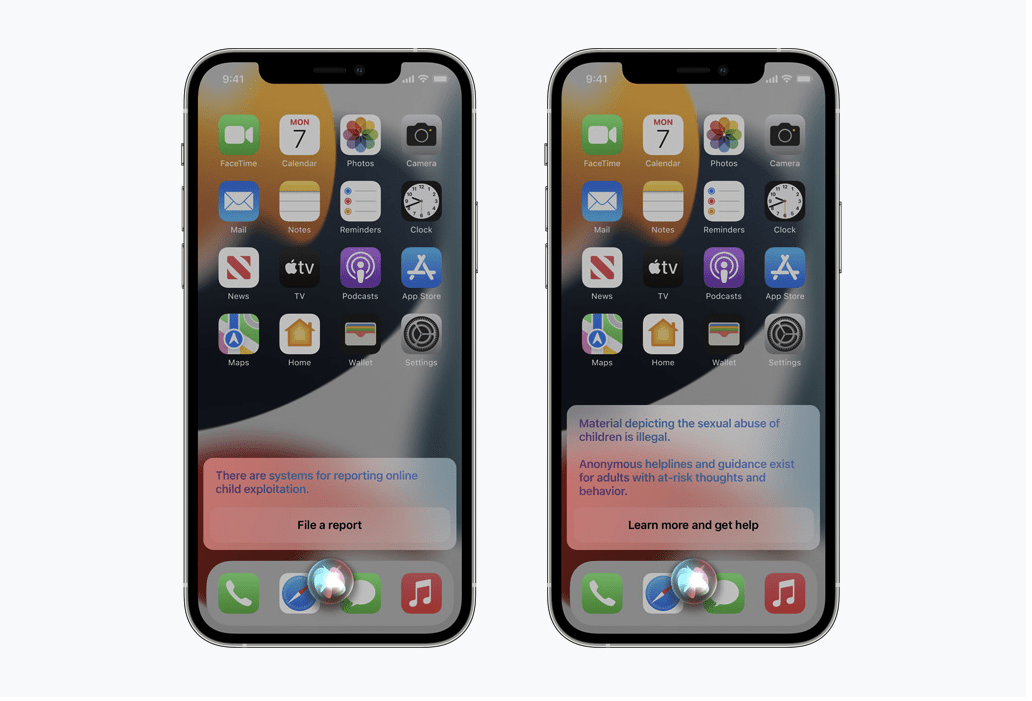

Siri hjälper till och håller vakande öga

Barn och vuxna kommer kunna fråga Siri om hjälp om hur de skall hålla sig säkra på nätet eller hur de skall göra om de upplever en situation om är obehaglig. Vidare kommer Siri säga till om systemet tycker att en användare söker på något den inte borde söka på i dessa sammanhang.

Kritik

Det är inte helt oproblematiskt när ett företag lägger sig i vad deras användare använder sin telefon till. I ett öppet brev som vem som helst kan skriva under tas det faktum upp att Apple nu skapar en bakdörr i vad som annars anses vara krypterad personlig information. En bakdörr som kan börja missbrukas och citerar CDT (Center for Democracy & Technology) som menar på att en ny norm skapas. En norm som gör det betydligt lättare för mindre nogräknade företag och regeringar jorden runt att övervaka och censurera.

EFF (Electronic Frontier Foundation) delar kritiken och sörjer det faktum att Apple tidigare var det företag som starkast tagit strid för end-to-end-kryptering, ofta till amerikanska polisväsendets stora förtret. EFF menar på att även om barns säkerhet på nätet är viktigt så är en bakdörr fortfarande en bakdörr. Med det menar de att det i slutändan är det omöjligt att bygga ett system som enbart kan användas till goda saker.

Och enligt principen små stegens tyranni, eller slippery slope på engelska, så riskerar Apple att tweaka systemet allteftersom för att inkludera fler typer av innehåll som man söker efter och varnar sina användare för.

Ett annat problem är vad Apples kan tvingas göra i vissa länder där exempelvis “homosexuell propaganda” är olagligt med hänsyn till barnen.

Alternativ

Än så länge gäller den nya given endast amerikanska användare. Men vill du användare en meddelandetjänst med end-to-end-kryptering utan möjlighet till någon bakdörr så finns Signal. Notera dock att om Apple får för sig att integrera funktionen på operativsystemnivå blir end-to-end-kryptering utan en bakdörr omöjligt på Apples plattform oavsett app.

När det kommer till fillagring är det egen NAS som gäller om du vill vara helt säker på att ingen söker igenom innehållet.